Google déploie BERT dans plusieurs langues

by Jérôme G.Le déploiement dans d'autres langues est annoncé pour la technologie BERT qui doit améliorer la compréhension du moteur de recherche Google.

Après l'anglais fin octobre, le déploiement de la technologie BERT dans d'autres langues - dont le français - a finalement lieu plus tôt que prévu.

Sans attendre 2020, il débute à partir d'aujourd'hui. Google vante toujours "la plus importante amélioration de ces cinq dernières années" de son moteur de recherche grâce à l'intelligence artificielle et en particulier le machine learning.

Le moteur de recherche devrait être mesure d'améliorer sa compréhension des requêtes longues ou complexes.

-----

Actualité publiée le 28 octobre 2019

Google est dithyrambique avec l'annonce du déploiement d'une amélioration de son algorithme de recherche. "Nous améliorons de manière significative notre compréhension des requêtes, ce qui représente le plus grand bon en avant des cinq dernières années et l'une des principales avancées dans l'histoire du Search", déclare Pandu Nayak, vice-président de la recherche chez Google.

Pour le moment, ce déploiement concerne la recherche en ligne en anglais. Une nouvelle technologie à base d'IA doit aider le moteur de recherche pour une meilleure compréhension des requêtes en langage naturel en tenant compte du contexte des mots.

L'amélioration devrait concerner une recherche sur dix aux États-Unis avec un impact sur le classement et l'affichage de résultats pertinents, dont les extraits optimisés (fatured snippets) dans les résultats de recherche. D'autres langues et pays seront concernés à l'avenir.

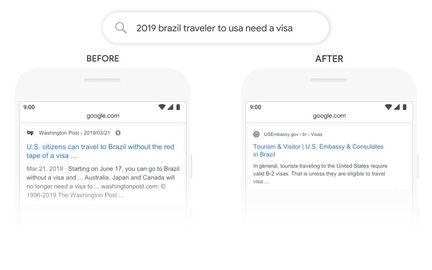

Parmi plusieurs exemples, Google cite celui d'une requête "2019 brazil traveler to usa need a visa." Avec le mot "to", la relation avec les autres mots clés de la requête sera interprétée afin de proposer une information pour un Brésilien qui voyage aux États-Unis. Auparavant, l'algorithme aurait renvoyé des résultats pour des citoyens américains voyageant au Brésil.

L'amélioration s'appuie sur un réseau de neurones artificiels baptisé BERT pour Bidirectional Encoder Representations from Transformers et qui concerne le traitement automatique du langage naturel. Google avait présenté BERT l'année dernière et en open source.

BERT est autrement assimilé à une nouvelle technique de pré-entraînement des algorithmes de traitement automatique du langage. Elle a été conçue pour le pré-entraînement de représentations bidirectionnelles profondes à partir du texte sans étiquetage. L'aspect bidirectionnel touche au contexte d'un mot. Le modèle pré-entraîné peut être affiné sans une modification profonde de l'architecture.

Avec BERT, c'est par ailleurs la première fois que Google utilise ses puces TPU (Tensor Processing Unit) pour des résultats de recherche. Ces puces sont spécialement conçues pour l'outil d'apprentissage automatique TensorFlow.

Google souligne néanmoins que même avec BERT, son moteur de recherche ne mettra pas dans le mille à tous les coups. "La compréhension du langage demeure un défi permanent."